如何快速导入超过1G的CSV文件和大型SQL文件到数据库

导入超大文件其实不是简单的点几下那么简单,大家肯定都碰到过文件大到让人抓狂的情况,别着急,今天给你详细拆解几种快速导入方法,保证你听了都觉得靠谱!

-

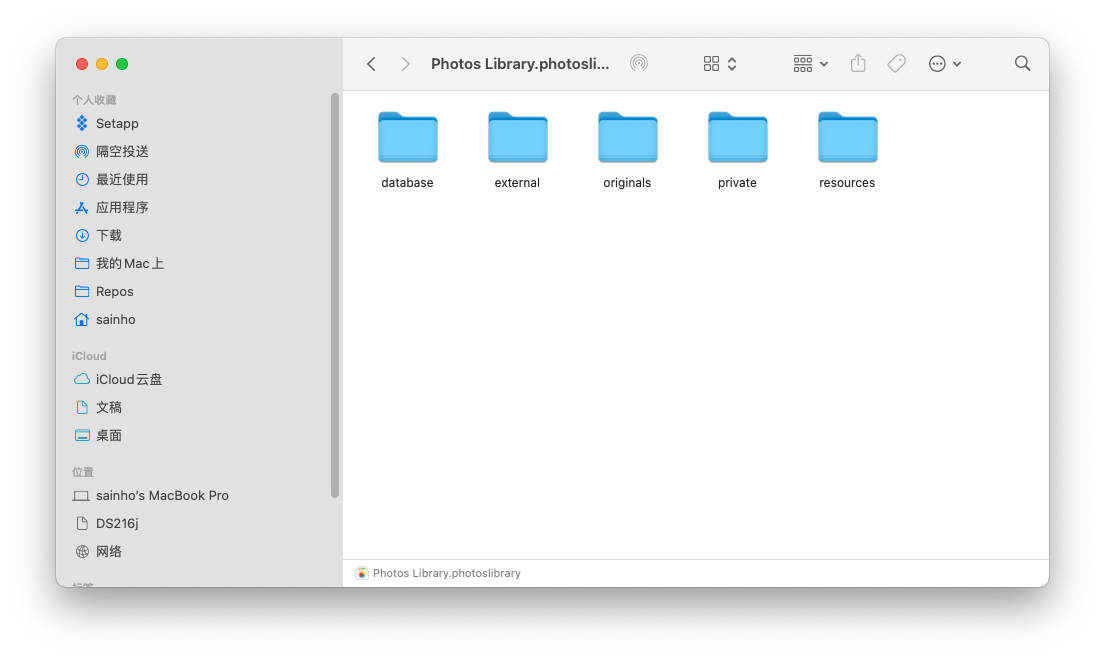

使用的卢导表工具导入大型CSV文件超级方便:

- 支持多数据库类型,比如MySQL、Oracle、SQL Server和PostgreSQL,轻松搞定各类数据库连接。

- 自动识别编码,省得你傻傻分不清UTF-8还是GBK什么的。

- 支持分批导入,避免一次性载入导致卡死,特别适合内存有限的小伙伴。

- 新建配置,设定目标表和导入任务,界面操作简单明了,很适合没那么多命令行经验的朋友。 -

针对大SQL文件,MySQL自带的source命令是个大神工具:

- 只需要登录MySQL客户端,输入source /path/to/yourfile.sql;,就能快速导入,既省心又省力。

- 对于SQL Server,bcp命令、BULK INSERT和OPENROWSET(BULK)都是加速利器。

- 大SQL文件建议先分割成多个小文件,再分批导入,避免一次性导入时数据库卡到怀疑人生。 -

其他工具的优化技巧:

- Navicat for MySQL虽然强悍,但导入13GB大文件超慢?别慌,建议先查看文件结构,必要时转换为LOAD DATA格式,再临时关闭索引检查,调大缓冲区,速度蹭蹭往上涨! -

导入大容量.sql文件用phpMyAdmin?其实有大限制!

- phpMyAdmin上传超大文件经常报错,内存和上传限制让人抓狂。建议使用gzip压缩文件以减小体积,也要考虑用命令行方式更靠谱。

导入工具选择与配置技巧 如何确保大文件快速且安全导入

选对工具和配置绝对是导入大文件的王道!不要一上来就用phpMyAdmin往里塞,那可能就是慢慢等咯,下面给你几个干货:

-

的卢导表操作小贴士:

- 连接测试别忘了做,失败了别傻等,赶紧检查账号密码啥的。

- 增加配置名方便后续管理,目标表选择完全不能马虎,错了数据全乱套。

- 记得分批加载和自动编码识别功能,特别适合不确定文件格式的神秘文件。 -

命令行操作优势:

- source命令既快又稳,懒人福音,可惜新手可能会觉得命令行吓人,但其实超简单。

- SQL Server的大容量导入工具功能丰富,大批量处理速度快得惊人。 -

文件优化与拆分策略:

- 超大SQL文件建议先用分割工具拆分成小块,更方便出错排查。

- Excel导入CSV数据也要选对接口,比如“获取外部数据”和Power Query,更智能处理分隔符和数据类型。 -

导入过程注意:

- 导入前先备份数据库,别怕麻烦,这可是救命稻草啊。

- 保持网络稳定,尤其是远程操作,卡顿可能造成导入失败。

- 关闭索引或延迟更新,减少写入瓶颈,导入完再重新建立索引,效果杠杠的!

相关问题解答

-

大文件CSV导入为何总是卡顿,有什么快速解决办法吗?

哎呀,这个问题太常见啦!导入大CSV文件,主要瓶颈在于内存和磁盘I/O。你可以试着分批导入——比如每次导入几万行,而不是一股脑全部丢进去。还有,选对工具超级关键,比如“的卢导表”这种支持断点续传的就特别省心。别忘了关闭索引检查,先把数据导进去,再开,速度瞬间飞起来! -

使用source命令导入SQL文件有什么注意事项?

嘿,source命令真的是MySQL导入大文件的救星!不过呢,文件路径最好写全写对了,路径里有空格就用引号包起来,免得报错。还有,导入时保证MySQL服务开着,账号权限别忘了确认,且建议先切换到目标数据库。最重要的是,大文件导入过程别点关闭窗口,耐心等它跑完啦! -

为什么phpMyAdmin导入大SQL文件总失败,有啥替代方案?

phpMyAdmin实在适合小文件,一旦超过几十MB就开始“翻车”了,主要是上传限制和内存限制。要解决这事儿,你可以用命令行导入(MySQL的source命令),或者用专业的导入工具,比如Navicat、DBeaver等。再不济就把SQL文件压缩成gzip格式,phpMyAdmin对压缩文件支持又好,又稳! -

Navicat导入超大SQL文件超慢怎么办?

Navicat导大文件卡得让人想砸电脑?别慌,其实它背后有不少优化技巧。比如你可以先用文本编辑器看下SQL文件结构,确认是不是有大量索引更新语句,建议导入时先暂时关闭索引重建,国外叫“disable indexes”,然后调高写缓冲区大小。还有,直接用LOAD DATA语句导入CSV文件比普通插入快很多,尝试转换格式也许更有戏喔!

新增评论